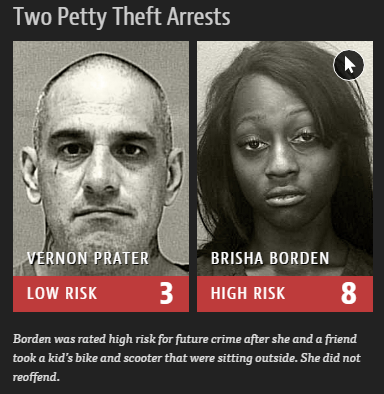

Sur Propublica, la journaliste Julia Angwin et le responsable données Jeff Larson signent une terrible enquête sur les biais racistes des algorithmes de prédiction des crimes (voir également “Quel est votre score de menace ?”). Ils évoquent en introduction un terrible exemple entre une jeune femme noire arrêtée pour un vol et un homme blanc d’une quarantaine d’année arrêté pour un crime similaire et condamné d’une manière proche. Le second ayant plus d’antécédents criminels que la première. Et bien le programme algorithmique utilisé par la police pour leur attribuer un score de menace classe la jeune femme comme bien plus à risque que l’homme. Deux ans plus tard, la jeune femme n’a pas commis d’autres crimes, alors que l’homme lui a été condamné pour un autre crime à 8 ans de prison.

L’évaluation automatique des risques criminels est de plus en plus courante dans de nombreuses courts de justice d’Etat américains et sont livrées aux juges lors de la condamnation pénale. En 2014, le procureur général Eric Holder s’inquiétait des risques que l’utilisation de ces scores faisaient peser sur les inégalités de la justice américaine, mais aucune étude d’évaluation de ces programmes n’a été lancé.

Les journalistes de ProPublica ont étudié les scores de risques attribués à plus de 7000 personnes arrêtées dans le comté de Broward en Floride entre 2013 et 2014. Si le l’algorithme prédit correctement la récidive à 61 %, les noirs ont deux fois plus de chance d’être évalué à plus haut risque que les blancs, indépendamment de leurs antécédents ou de la récidive. Les accusés noirs sont 77 % plus susceptibles d’être indexés à risque de commettre un crime violent et 45 % plus susceptibles d’être indexés à risque de commettre un crime de toute nature. La société qui fournit l’algorithme du score de menace, mise en cause par ProPublica, Northpointe, récuse les accusations des journalistes.

Reste que l’accusation des journalistes de ProPublica est terrible. Ils rapportent par exemple l’influence de ce score sur la condamnation d’un homme coupable d’avoir volé une tondeuse à gazon, contre lequel le procureur avait requis un an de prison, mais qui a écopé de deux ans de prison et trois ans de surveillance du fait de son score de menace désastreux. Et les auteurs de rappeler que les prévenus ne peuvent contester leurs évaluations, notamment parce que les données sous-jacentes au calcul de ces scores (provenant de réponses à quelques 137 questions, affirme Northpointe) ne leur sont pas disponibles. Pour Christopher Slobogin, directeur du programme de justice pénale de l’école de droit Vanderbilt, ses données devraient être accessibles aux deux parties et donner lieux à une procédure contradictoire ouverte.

MAJ : Andrea Fradin pour Rue89 revient également sur le sujet :

“. Les personnes noires sont plus souvent considérées comme étant hautement susceptibles de récidiver, sans que ce soit suivi de faits (44,9 % des Afro-américains classés dans cette catégorie n’ont pas commis d’autres crimes, contre 23,5 % de personnes blanches).

. Les personnes blanches, à l’inverse, sont considérées moins risquées qu’elles ne devraient l’être (47,7 % de personnes blanches classés dans cette catégorie ont récidivé, contre 28 % de personnes noires).

. Les personnes noires ont deux fois plus de chance d’être considérées, à tort, comme potentielles récidivistes violentes.

. Les personnes blanches récidivistes et accusées de crimes violents par le passé ont 63 % plus de chances de se voir attribuer, à tort, un faible risque de récidive violente, par rapport à un criminel noir au même profil.”

“Un type qui violente un enfant tous les jours pendant un an obtiendra peut-être un score de risque faible parce qu’il a un boulot. Alors qu’un type arrêté pour ivresse publique obtiendra un score élevé parce qu’il est sans domicile fixe. Les facteurs de risque ne vous disent pas si une personne doit aller en prison ; ils vous disent surtout quels sont les bons critères fixer pour une mise à l’épreuve.”

Sur son compte Facebook, Antoinette Rouvroy conclu : “Naturalisation des préjugés sociaux. Tant que l’on ne s’intéressera pas aux circonstances et conditions de production des “données” qui les nourrissent, les machines ne feront jamais que refléter passivement, tout en les immunisant (partiellement) de la critique, les biais et préjugés sociaux dominants. Ce ne sont pas tant les machines (les algorithmes) qui sont en cause, que la manière dont nous produisons et enregistrons les données à propos de la réalité sociale. Des données amnésiques de leur contexte de production naturalisent les normes sociales, biais et préjugés, en faisant passer pour des “faits” relevant d’une “physique sociale”, les effets de nos biais et préjugés.”

MAJ : l’avocat et scientifique de données David Colarusso a utilisé un jeu de données criminel en provenance de Virginie pour mesurer ce qui affecte le plus la durée d’une sentence : les revenus ou l’origine ethnique… Sa conclusion est sans appel : “Pour qu’un homme noir de Virginie ait le même traitement qu’un de ses pairs blancs, il doit gagner plus de 500 000 dollars par an !”